Article

Une machine peut-elle ressentir de l'émotion ?

Une machine peut-elle ressentir de l'émotion ?

Mohamed Daoudi

Professeur IMT Lille Douai, CRIStAL (UMR 9189)

De grandes sociétés technologiques comme Microsoft, Apple et Amazon, ainsi que des startups comme Kairos et Affectiva, vendent des produits pour reconnaitre plusieurs expressions faciales des visages. Il existe aujourd’hui une vingtaine d’APIs qui proposent de détecter et de reconnaitre des expressions faciales. La colère, la tristesse, la joie, la surprise, la peur et le dégoût sont six émotions qui se traduisent chez l’humain par des expressions faciales (Figure 1). Une constante prouvée par les travaux du psychologue Paul Ekman publiés dans les années 1960 et 1970. Presque 50 ans plus tard, les scientifiques utilisent ces résultats pour automatiser la reconnaissance des expressions faciales à partir de vidéos par des algorithmes d’Intelligence Artificielle. Dans cet article, je vous présente des algorithmes récents que nous avons développés qui permettent la reconnaissance des expressions faciales. Ces algorithmes fonctionnent à partir de séquence vidéo de visages ou à partir de points caractéristiques (appelés en anglais des landmarks) détectés sur les visages.

Figure 1 : Des exemples d’images d’expressions faciales extraites de la base CK+

Les algorithmes qui reconnaissent les expressions faciales à partir de points caractéristiques nécessitent tout d’abord la détection de ces points. Cette opération est effectuée d’une manière automatique pour chaque image d’une vidéo par l’utilisation des techniques d’apprentissage profond. Une fois cette étape terminée, Il est nécessaire de disposer d’une modélisation de la dynamique du visage sous forme de points qui évoluent dans le temps. Cette étape est ensuite suivie par une étape de d’apprentissage automatique qui va apprendre les dynamiques associées à chacune des expressions faciales. La figure 2 montre un exemple de résultat obtenu avec notre algorithme.

Figure 1 : Une capture d’écran d’un logiciel de reconnaissance des expressions à part des points caractéristiques (https://www.youtube.com/watch?v=2DENlPFIjAg). Cette figure montre un visage avec les points caractéristiques associés et le résultat de la classification.

Plusieurs recherches ont montré l’efficacité des méthodes utilisant les landmarks pour la reconnaissance des expressions faciales. Néanmoins ces méthodes sont beaucoup affectées par la performance des algorithmes utilisés pour la détection des points caractéristiques.

Dans une autre direction, l’utilisation des images texturées permet d’utiliser toute l’information contenue dans les images des expressions faciales. Sur cette idée sont basées les méthodes de l’apprentissage profond des réseaux de neurones convolutifs (DCNN), qui ont démontré leur efficacité dans plusieurs tâches de classification à partir des images y compris la reconnaissance des expressions faciales. Ces réseaux de neurones sont généralement constitués d’une succession des couches de convolution, d’activation non-linéaire et des couches de pooling qui sont entraînés à déterminer automatiquement dans l’image d’entrée, les caractéristiques pertinentes liées aux expressions faciales.

En entraînant un tel réseau sur une quantité des données suffisante, on obtient un modèle capable de déterminer les caractéristiques pertinentes et spécifiques à chaque expression faciale. Ces caractéristiques sont par la suite classées par la couche softmax qui constitue la dernière couche du réseau, et qui est responsable de la classification des caractéristiques extraites à partir de chaque image d’entrée.

La figure 1 illustre un exemple de réseau de neurones à convolution utilisé pour la classification des expressions faciales.

Figure 1 : Illustration d’un réseau de neurones à convolution utilisé pour la classification des expressions faciales. L’image d’entrée correspondant à une expression faciale est traitée par une succession des couches pour en extraire les caractéristiques pertinentes à l’expression faciale. Finalement, ces caractéristiques sont classées par la couche softmax.

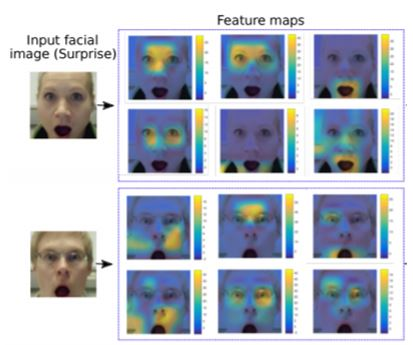

La figure 2 représente une visualisation de 6 cartes de caractéristiques parmi les 512 cartes totales, extraites de la dernière couche de convolution du réseau de neurones. Ces cartes sont superposées sur l’image d’entrée qui correspond à l’expression surprise. Il est assez remarquable, dans ces visualisations, que les neurones actifs correspondent à des régions du visage qui ont subi des déformations liées aux expressions faciales. Cette figure démontre que les réseaux de neurones sont capable de déterminer automatiquement dans l’image d’entrée, les informations pertinentes à l’expression faciale.

Figure 1 : Visualisation des cartes de caractéristiques extraites de la dernière couche d’un réseau DCNN. Ces cartes de caractéristiques sont superposées sur les images d’entrée.

L’analyse et la reconnaissance des expressions faciales ouvrent aujourd’hui des nouvelles perspectives dans le domaine de la santé. En psychiatrie, les praticiens regardent beaucoup les expressions pour obtenir des indications sur l’état psychologique d’un patient en particulier ceux qui souffrent de dépression sévère. L’analyse du visage et des expressions pourraient aider le psychiatre à mieux évaluer d’une manière plus objective l’effet du traitement administré au patient. Étudier rigoureusement l’évolution du visage peut permettre aussi de détecter la douleur chez certains patients qui ont du mal à l’exprimer.

Par ailleurs, on ne peut terminer cet article sans mentionner les aspects éthiques concernant, d’une part les difficultés liées à l’analyse des émotions à partir des expressions faciales hors contexte de la personne étudiée, et d’autre part les biais culturels ou liés au genre qui doivent être pris en compte lors de la collecte des bases d’apprentissage.

Références

Anis Kacem, Mohamed Daoudi, Boulbaba Ben Amor, Stefano Berretti, and Juan Carlos Álvarez Paiva. A novel geometric framework on gram matrix trajectories for human behavior understanding. IEEE Transactions on Pattern Analysis and Machine Intelligence, 42(1) :1–14, 2020.

Naima Otberdout, Anis Kacem, Mohamed Daoudi, Lahoucine Ballihi, and Stefano Berretti. Automatic analysis of facial expressions based on deep covariance trajectories. IEEE Transactions on Neural Networks and Learning Systems, pages 1–14, 2019.

Anis Kacem, Zakia Hammal, Mohamed Daoudi, and Jeffrey F. Cohn. Detecting depression severity by interpretable representations of motion dynamics. In 13th IEEE International Conference on Automatic Face & Gesture Recognition, FG 2018, Xi’an, China, May 15-19, 2018, pages 739–745, 2018